Ве молиме кликнете двапати на англискиот титл подолу за да го репродуцирате видеото.

New videos

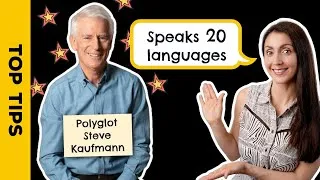

Оваа страница ќе ве запознае со видеата на YouTube кои се корисни за учење англиски јазик. Ќе гледате часови по англиски јазик кои ги учат врвни наставници од целиот свет. Кликнете двапати на англиските преводи прикажани на секоја видео страница за да го репродуцирате видеото од таму. Преводите се движат синхронизирано со репродукцијата на видеото. Ако имате какви било коментари или барања, ве молиме контактирајте не користејќи ја оваа контакт форма.